TensorBoard 无法显示数据?大日志背后的可见性陷阱

1. 现象描述:

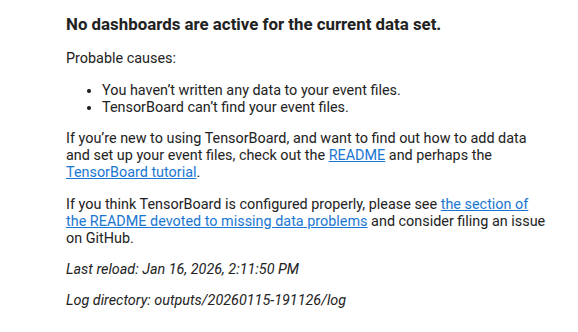

在服务器上进行深度学习训练,并用Tensorboard记录训练日志,但是发现某一个实现日志在通过浏览器打开Tensorboard页面之后没有数据显示,而是产生了下面的警告:

一般这种警告是因为日志中没有数据写入,比如实验刚运行起来就终止了。但是我确定我的这个日志中是有数据写入的,因为同一时间运行起来的另一个实验的日志是能正常用Tensorboard打开显示数据的,并且执行以下的命令:

1 | |

有以下输出:

1 | |

这个event文件的大小高达489M,很明显是有数据写入的。

而当我点击页面右上角的Reload按钮之后,日志中的数据就成功加载出来了。

2. 原因分析

查阅之后发现,这背后可能涉及到Tensorboard的扫描机制和Linux系统的文件写入缓存策略。

A. 初始扫描的时机矛盾

Tensorboard启动时会执行一次全量目录扫描。

- 如果启动时,训练程序正处于高频写入状态,Linux文件系统可能会对该文件施加临时的读取限制。

- Tensorboard若在第一轮扫描时未能成功解析文件头,会将其标记为“无效”或“空”,并在前端显示默认的错误提示。

B. 写入缓冲区延迟

Python的SummaryWriter 写入数据并非实时落盘,而是遵循:内存缓存 -> 系统 I/O 缓存 -> 磁盘文件 。

- 即使

1s命令显示文件有几百兆,但如果文件的索引元数据(Index Blocks)尚未从缓冲区中刷新到磁盘,Tensorboard的后端解析器就无法构建时间序列轴,导致前端认为“没有数据”。

C. 超大文件的解析负载(最可疑)

- 489MB是一个相当大的Event文件。初次加载时,后端需要解析数万个Steps的数据。

- 如果后端计算压力过大导致响应超时,前端UI会提前放弃等待并触发“No dashboard”的占位提示。

3. 解决方法与最佳实践

方案一:强制手动刷新

就像本次解决的方式一样,点击右上角的Reload按钮

- 原理:这会强制Tensorboard后端重新执行一次磁盘I/O扫描,并跳过之前的缓存状态,重新解析已落盘的数据块。

方案二:调整启动目录层级

如果logdir 指向过深,有时会影响扫描效率。尝试将路径向上一级移动。

方案三:代码层面优化

在训练脚本中,建议在关键节点手动刷新缓冲区,确保Tensorboard能够实时获取数据:

1 | |

TensorBoard 无法显示数据?大日志背后的可见性陷阱

https://misaka0502.github.io/2026/01/16/tensorboard-data-loading/